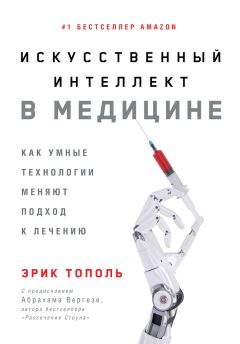

Автор книги: Эрик Тополь

Жанр: Прочая образовательная литература, Наука и Образование

Возрастные ограничения: +12

сообщить о неприемлемом содержимом

Текущая страница: 9 (всего у книги 27 страниц) [доступный отрывок для чтения: 9 страниц]

Предрассудки и неравенство

В книге «Убийственные большие данные»[169]169

О’Нил К. Убийственные большие данные: Как математика превратилась в оружие массового поражения. – М.: АСТ, 2018.

[Закрыть] Кэти О’Нил замечает, говоря о моделях экономики больших данных, что «многие из этих моделей вставляли предубеждения, непонимание и предвзятость, свойственные каждому живому человеку, в программное обеспечение, которое во все большей степени управляло нашими жизнями»[170]170

O’Neil, C., Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. 2016. New York: Crown.

[Закрыть]. Естественная человеческая пристрастность встроена и в наш алгоритмический мир: она повсеместно влияет на восприятие гендерной, расовой, этнической, социально-экономической, классовой и сексуальной идентичности. Влияние может быть самым серьезным, так как от него зависит, кого примут на работу или даже допустят до собеседования, как ранжируют специалистов, как будет осуществляться уголовное правосудие, кому дадут или не дадут кредит. Насколько глубока эта проблема, можно проиллюстрировать несколькими примерами.

В статье, озаглавленной «Мужчины тоже любят шопинг», рассказывается о том, как группа исследователей оценила две коллекции изображений, каждая из которых состояла более чем из 100 тыс. сложных фотографий с детальной маркировкой[171]171

Zhao, J., et al., Men Also Like Shopping: Reducing Gender Bias Amplification Using Corpus-Level Constraints. arXiv, 2017.

[Закрыть]. На фотографиях был представлен предсказуемый гендерный предрассудок: шопинг и готовка были связаны с женщинами, а спорт, консультирование и стрельба – с мужчинами. Очевидное искажение на выходе: мужчина на кухне был маркирован как «женщина». Хуже того – если машину обучали распознаванию образов на основании предрассудков, она умножает и углубляет эти предрассудки. В процесс обучения был внедрен метод ослабления предрассудков, но он требует, чтобы автор кода искал случаи срабатывания предрассудков и определял, что надо исправить. И даже если это делается, то проблема все равно присуща исходному массиву данных[172]172

Simonite, T., “Machines Taught by Photos Learn a Sexist View of Women,” Wired. 2017.

[Закрыть]. Другой вопиющий пример гендерных предрассудков демонстрирует исследование Университета Карнеги—Меллона: было обнаружено, что алгоритмы Google показывают рекламу высокооплачиваемой работы мужчинам чаще, чем женщинам[173]173

Spice, B., “Questioning the Fairness of Targeting Ads Online,” Carnegie Mellon University News. 2015.

[Закрыть].

Исследование с помощью искусственного интеллекта огромного корпуса текста из Всемирной паутины, включающего 840 млрд слов, показало широчайшую распространенность гендерных и расовых предрассудков, а также других примеров негативного отношения (скажем, к больным психическими расстройствами) и использования уничижительных прозвищ для пожилых людей[174]174

Caliskan, A., J. J. Bryson, and A. Narayanan, “Semantics Derived Automatically from Language Corpora Contain Human-Like Biases.” Science, 2017. 356 (6334): pp. 183–186.

[Закрыть]. Использование сети как источника данных для этого исследования просто вывело на передний план наши исторические, запечатленные в культуре предрассудки и предубеждения. Когда ИИ сервиса Google Photos в 2015 г. ошибочно принял чернокожего мужчину за гориллу, это вызвало довольно серьезный резонанс в обществе. В разоблачительном материале ProPublica, озаглавленном «Предрассудки машин», были представлены шокирующие свидетельства: широко используемый коммерческий алгоритм ошибочно предсказывал высокий уровень риска совершения новых преступлений для чернокожих, имеющих судимость. Степень риска рецидива для белых автоматически занижалась[175]175

Angwin, J., et al., “Machine Bias,” ProPublica. 2016.

[Закрыть]. Были выявлены ущемляющие бедных предрассудки в алгоритмах, которые использует полиция для прогнозирования, где именно произойдет то или иное преступление[176]176

O’Neil, Weapons of Math Destruction.

[Закрыть], а пресловутый «гей-радар», который по выражению лиц якобы способен распознавать сексуальную ориентацию, являет собой пример предвзятости по отношению к гомосексуалам[177]177

Wang, Y., and M. Kosinski, “Deep Neural Networks Are More Accurate Than Humans at Detecting Sexual Orientation from Facial Images.” Journal of Personality and Social Psychology, 2018. 114 (2): pp. 246–257.

[Закрыть].

Предвзятость проникает в мир ИИ самыми непредсказуемыми путями, но важно отслеживать эти пути. Рассмотрим для примера разработку приложения под названием NamePrism, которое должно было, по мысли авторов, выявлять и предупреждать дискриминацию[178]178

Chen, S., “AI Research Is in Desperate Need of an Ethical Watchdog,” Wired. 2017.

[Закрыть]. Приложение, созданное в Университете Стоуни-Брук в сотрудничестве с несколькими ведущими интернет-компаниями, представляет собой алгоритм машинного обучения, который определяет по имени этническую и национальную принадлежность человека на основании миллионов усвоенных имен. Точность определения составляет приблизительно 80 %. Запуская приложение, создатели и не предполагали, что его будут использовать для пропаганды дискриминации, но произошло именно это[179]179

Snow, J., “New Research Aims to Solve the Problem of AI Bias in ‘Black Box’ Algorithms,” MIT Technology Review. 2017.

[Закрыть].

Недостаточное культурно-личностное многообразие среди людей, работающих в ведущих ИТ-компаниях, а также среди высшего руководства компаний, отнюдь не помогает решать подобные проблемы. Преобладание белых мужчин во многих компаниях усложняет задачу выявления гендерных предрассудков в отношении женщин и требует особого внимания, так как здесь не помогут алгоритмы искусственного интеллекта.

Институт AINow, обратившись к проблеме предвзятости и дискриминации, рекомендует применять «строгие правила проверки систем искусственного интеллекта перед их запуском, чтобы удостовериться, что они не умножат число предубеждений и ошибок в связи с погрешностями в обучающих данных, алгоритмах или других элементах системного проектирования». Необходимо, кроме того, тщательное отслеживание любых проявлений предвзятости, и в этом смысле многие очень надеются на помощь искусственного интеллекта[180]180

Snow, “New Research Aims to Solve the Problem of AI Bias in ‘Black Box’ Algorithms,” MIT Technology Review. 2017; Tan, S., et al., Detecting Bias in Black-Box Models Using Transparent Model Distillation. arXiv, 2017.

[Закрыть]. Кейт Кроуфорд, директор института, резюмирует: «Когда ИИ становится новой инфраструктурой, незаметно, как вода из крана, вливающейся в нашу повседневную жизнь, мы должны осознавать, какими окажутся ее краткосрочные и долгосрочные эффекты, поскольку это залог нашей безопасности»[181]181

Crawford, K., “Artificial Intelligence – with Very Real Biases,” The Wall Street Journal. 2017.

[Закрыть]. Были предприняты значительные усилия для систематической проверки алгоритмов как средств обеспечения прозрачности и честности[182]182

Vanian, J., “Unmasking A. I.’s Bias Problem,” Fortune. 2018; Courtland, R., “Bias Detectives: The Researchers Striving to Make Algorithms Fair,” Nature. 2018.

[Закрыть]. И действительно – искусственный интеллект использовали для проверки на гендерную предвзятость статей «Википедии»[183]183

Simonite, T., “Using Artificial Intelligence to Fix Wikipedia’s Gender Problem,” Wired. 2018.

[Закрыть], причем это вызвало дискуссию, является ли искусственный интеллект менее предвзятым, чем люди[184]184

Miller, A. P., “Want Less-Biased Decisions? Use Algorithms,” Harvard Business Review. 2018; Thomas, R., “What HBR Gets Wrong About Algorithms and Bias,” Fast AI. 2018.

[Закрыть].

Предвзятость в медицине уже давно стала объектом системных исследований, потому что пациенты, попавшие в число испытуемых при проведении клинических исследований, редко отображают все многообразие населения. Меньшинства представлены недостаточно, а иногда их и вовсе не включают в исследования. В геномных исследованиях это особенно заметно по двум причинам. Первая – люди европейского происхождения составляют большинство испытуемых в когортных исследованиях (а порой и вся выборка состоит из белых европейцев). Вторая, следующая из первой, – результаты этих исследований представляют ограниченный интерес для большинства людей в мире, так как многие врожденные генетические заболевания зачастую специфичны для людей определенного происхождения. Применение таких данных в качестве обучающей информации для искусственного интеллекта, а затем использование результатов для прогнозирования и лечебных рекомендаций для всех без исключения людей – прекрасный способ создать большие проблемы. Примером может служить диагностика рака кожи средствами искусственного интеллекта. Этот метод редко применяют для диагностики кожных поражений у людей с небелым цветом кожи[185]185

Adamson, A. S., and A. Smith, “Machine Learning and Health Care Disparities in Dermatology.” JAMA Dermatology, 2018.

[Закрыть].

Потенциальная способность ИИ усугубить и без того существенное (причем продолжающее увеличиваться во многих странах, включая и США) экономическое неравенство также имеет непосредственное отношение к медицине. Харари в своей книге «Homo Deus» рассуждает: «В прошлом веке целью медицины было лечение больных. В XXI веке медицина все больше перестраивается на усовершенствование здоровых»[186]186

Harari, Y. N., Homo Deus. 2016. New York: HarperCollins, p. 348.

[Закрыть]. Эти опасения разделяет и Кай-Фу Ли, один из наиболее признанных в Китае и в мире специалистов по искусственному интеллекту: он подчеркивает, что «даже в богатых и технологически развитых странах ИИ углубит пропасть между имущими и неимущими», а также указывает, как важно учитывать социальные последствия внедрения систем ИИ, и по возможности как преднамеренные, так и непреднамеренные[187]187

Lee, K. F., “The Real Threat of Artificial Intelligence,” The New York Times. 2017.

[Закрыть]. Пристрастность и предрассудки, характерные для ИИ, – это двойной удар по низшим социально-экономическим слоям населения: такие люди наиболее уязвимы в плане потери работы, и, кроме того, доступ к медицинским инструментам ИИ для них затруднен. Чтобы преодолеть эту проблему, нам нужна продуманная стратегия обеспечения всеобщей доступности полезных инструментов ИИ.

Замазывание правды

Мир фейковых новостей, фейковых изображений, фейковых речей и фейковых видео – это отчасти продукт результатов внедрения искусственного интеллекта. Мы видели, как создатели фейковых новостей в Facebook, нацеленных на определенную аудиторию, использовали их для нагнетания ситуации вокруг президентских выборов 2016 г. в США и как рекламные отделы различных компаний используют в интернете ИИ, чтобы соблазнять людей своей продукцией (а кто-то скажет – подсаживать на нее людей, как наркоманов на иглу). Проблема эта со временем только усугубляется. Уже давно говорится, как ретушь, а теперь и компьютерную обработку изображений можно использовать для того, чтобы заставить нас видеть то, что надо. Эти манипуляции достигли небывалых масштабов, фабрикуются великолепного качества фейки – не только перерисовываются изображения, нет, переписывается сама реальность… с использованием инструментов ИИ.

Специалисты стартапа Lyrebird научились, используя фрагменты записей голоса того или иного человека, фабриковать совершенно аутентичный звук[188]188

Upson, S., “Artificial Intelligence Is Killing the Uncanny Valley and Our Grasp on Reality,” Wired. 2017.

[Закрыть]. А ИИ-алгоритм, названный Houdini (в честь иллюзиониста Гудини), может перехватывать аудиофайлы и изменять их так, чтобы звучание казалось прежним, а другие ИИ-алгоритмы (например, GoogleVoice) улавливали в записи совершенно другие слова[189]189

Condliffe, J., “AI Shouldn’t Believe Everything It Hears,” MIT Technology Review. 2017.

[Закрыть]. Алгоритмы позволяют редактировать порнофильмы – переносить лица знаменитостей (скажем, Галь Гадот, звезды фильма «Чудо-женщина»), на тела других людей[190]190

Cole, S., “AI-Assisted Fake Porn Is Here and We’re All Fucked,” Motherboard. 2017.

[Закрыть]. Ученые Вашингтонского университета использовали нейросети для создания видео, в котором практически невозможно опознать фейк: они сделали видеоклип с «речью» президента Обамы (в реальности он никогда ее не произносил)[191]191

Suwajanakorn, S., S. M. Seitz, and I. Kemelmacher-Shlizerman, “Synthesizing Obama: Learning Lip Sync from Audio.” ACM Transactions on Graphics, 2017. 36 (4): pp. 1–13.

[Закрыть].

Очень часто с такими целями применяется одна из разновидностей искусственного интеллекта, известная под названием «генеративно-состязательная сеть» (ГСС; generative adversarial networks (GAN)). ГСС были изобретены Яном Гудфеллоу в 2014 г. Сам автор считал, что прогресс в области синтеза изображений не так быстр, как в области распознавания. По стопам Гудфеллоу последовали и другие – например, компания NVIDIA, создавшая более эффективные ГСС, которые оказались способны выдавать фейковые изображения знаменитостей с непревзойденным качеством[192]192

Knight, W., “Meet the Fake Celebrities Dreamed Up by AI,” MIT Technology Review. 2017; Karras, T., et al., Progressive Growing of GANs for Improved Quality, Stability, and Variation. arXiv, 2017.

[Закрыть]. А вскоре появились и многочисленные усовершенствования ГСС (CycleGAN, DiscoGAN, StarGAN и pix2pixHD), и все они еще сильнее затрудняют саму возможность отличить реальное изображение от фейкового. Похоже, манипуляциям с контентом любого типа нет никакого предела, что окончательно размывает границы достоверности. А это отнюдь не то, что нам нужно в эпоху коррозии правды.

Конфиденциальность и хакерство

Уже давно раздаются крики, что «тайны частной жизни больше нет». Прогресс в области точного распознавания лиц отнюдь не развеял эти опасения. Такие алгоритмы глубоких нейронных сетей, считывающие и распознающие лица, как FaceNet от Google, FaceID от Apple и DeepFace от Facebook, могут легко распознать конкретное лицо из миллиона других – а мы знаем, что изображения лиц половины взрослых жителей США хранятся по крайней мере в одной из баз данных, доступных для полиции. А данные о лице, известные ИИ, – это только один из способов идентификации человека. Искусственный интеллект можно приложить и к геномным данным, что помогло найти серийного убийцу в Калифорнии. Янив Эрлих, генетик и специалист по реидентификации, утверждает: «В ближайшем будущем можно будет идентифицировать практически любого жителя США европейского происхождения», причем сделать это можно будет с помощью геномных баз данных, доступных широкому пользователю[193]193

Erlich, Y., et al., Re-identification of Genomic Data Using Long Range Familial Searches. bioRxiv, 2018.

[Закрыть]. Кроме того, существуют и другие надежные биометрические признаки, такие как рисунок сетчатки или электрокардиограмма. Над нами витает оруэлловский призрак – всевидящее око искусственного интеллекта: ведь вокруг все больше и больше камер видеонаблюдения, которые облегчают идентификацию, нарушая право личности на приватность.

История с DeepMind, компанией искусственного интеллекта, и Королевским свободным фондом Национальной службы здравоохранения (NHS) в Лондоне, имевшая место в 2017 г., иллюстрирует напряженность, царящую в медицинских кругах[194]194

Shead, S., “Google DeepMind Has Doubled the Size of Its Healthcare Team,” Business Insider. 2016; Shead, S., “DeepMind’s First Deal with the NHS Has Been Torn Apart in a New Academic Study,” Business Insider. 2017.

[Закрыть]. В ноябре 2015 г. NHS поручила компании DeepMind Technologies, дочерней компании Google/Alphabet, перенести базу данных электронных медицинских записей с идентификаторами пациентов (без прямого их согласия на распространение) из системы NHS в систему компании. Данные касались 1,6 млн граждан Великобритании за предыдущие пять лет. Целью была разработка приложения для смартфонов под названием Stream, которое должно было, по мысли создателей, привлечь внимание медиков к заболеваниям почек, являющимся в Англии причиной 40 тыс. смертей в год. Стремление решить эту проблему было само по себе похвальным, но в то время DeepMind имела очень небольшой опыт работы со службами здравоохранения. Имели место и явные опасения по поводу того, что компания, принадлежащая Google, крупнейшему рекламному предприятию мира, получит доступ к таким данным, хотя DeepMind многократно заверяла, что полученные ею данные «никогда не будут связаны или ассоциированы с аккаунтами, продуктами или службами Google»[195]195

Там же.

[Закрыть]. Это был ключевой пункт соглашения. Когда я посетил Verily, еще одну дочернюю компанию Google, специализирующуюся на здравоохранении, ее генеральный директор сказал мне, что за решением отделиться стояло (отчасти) соображение о том, чтобы новую компанию никак не связывали с Google.

Каковы бы ни были заверения компании, ни у кого не было возможности проследить, что именно было сделано с огромным массивом данных о пациентах NHS, куда были включены данные о передозировках лекарств, абортах, лечении психических заболеваний, положительных анализах на ВИЧ и многое другое. К концу 2017 г. британские регулирующие органы постановили, что данные были переданы в обход законодательства[196]196

Kahn, J., “Alphabet’s DeepMind Is Trying to Transform Health Care – but Should an AI Company Have Your Health Records?” Bloomberg. 2017.

[Закрыть]. DeepMind, откликнувшись на озабоченность, в конце концов создала цифровую систему учета, чтобы аудиторы могли в любой момент выяснить, кто именно и когда получал доступ к данным любого пациента. Конечно, лучше бы такая система была внедрена с самого начала проекта – для гарантии конфиденциальности и безопасности.

В конечном счете все обернулось хорошо: приложение Stream, разработанное компанией DeepMind и бесплатно переданное NHS, прекрасно функционирует и значительно сократило время поиска важной информации о пациентах, имеющей отношение к нарушениям функции почек. Этим приложением активно пользуются медицинские сестры, врачи и группы по защите прав пациентов. Процитируем высказывание Сары Стенли, одной из медсестер, пользующихся приложением: «Мы только что определились с одним пациентом за 30 секунд. Раньше сортировка заняла бы не меньше четырех часов»[197]197

Kahn, J., “Alphabet’s DeepMind Is Trying to Transform Health Care.”

[Закрыть]. Проект был всецело поддержан и Николь Перрин, главой Understanding Patient Data – организации по медико-информационному просвещению пациентов: «Думаю, очень важно, что мы не стали зацикливаться на проблемах и рисках и не упустили потенциальные преимущества работы с компанией, которая обладает такими ресурсами и опытом, да еще и хочет при этом заниматься здравоохранением»[198]198

Там же.

[Закрыть]. Джо Ледсэм из команды по изучению ИИ компании DeepMind резюмировал: «Нам следует более, а не менее внимательно относиться к рискам и безопасности моделей».

Разбор случая с DeepMind помогает поднять на поверхность множество важных проблем с медицинской конфиденциальностью, связанных с большими данными: отсутствие официального согласия пациентов, отсутствие прозрачности и обострение технофобии – страх чрезмерного влияния современных технологий на жизнь частных лиц лишь усиливается на фоне олигополии крупнейших ИТ-титанов (Google, Amazon, Apple, Facebook, Microsoft), всерьез занявшихся здравоохранением. Недаром этот интерес привел к созданию важного продукта, который помог и медикам, и пациентам, а из опыта его разработки и использования были извлечены ценные уроки[199]199

Shead, “Google DeepMind Has Doubled the Size of Its Healthcare Team”; Shead, “DeepMind’s First Deal with the NHS Has Been Torn Apart in a New Academic Study.”

[Закрыть].

Еще один пример потенциального нарушения конфиденциальности в связи с глубоким обучением описан в статье, опубликованной в издании Proceedings of the National Academy of Sciences[200]200

Gebru, T., et al., “Using Deep Learning and Google Street View to Estimate the Demographic Makeup of Neighborhoods Across the United States.” Proceedings of the National Academy of Sciences of the United States of America, 2017. 114 (50): pp. 13108–13113; Lohr, S., “How Do You Vote? 50 Million Google Images Give a Clue,” The New York Times. 2017.

[Закрыть]. Собрав воедино 50 млн общедоступных изображений 22 млн автомобилей, сделанных системой Google Street View в 200 городах, ученые лаборатории ИИ Стэнфордского университета и их ассистенты смогли точно установить электоральные предпочтения, расовую принадлежность, уровень образования и доходов их владельцев по индексу или по полицейскому округу. И хотя использование алгоритмов глубокого обучения не позволяет установить личность или точный адрес проживания, можете быть уверены: многие ИТ-компании располагают соответствующими данными и, имея в своем распоряжении специалистов по глубоким нейронным сетям, могут извлечь из этих данных всю необходимую информацию. Самый известный случай такого рода – это обширный массив данных организации Cambridge Analytica, содержащий личные сведения о большинстве взрослых граждан США и сформированный путем извлечения данных Facebook: все закончилось громкими обвинениями в попытках повлиять на исход президентских выборов 2016 г. и в алгоритмически таргетированной рассылке фейковых новостей[201]201

Campolo et al., AI Now 2017 Report.

[Закрыть].

Опасения по поводу возможных хакерских атак были подкреплены случаями автоматизированных киберпреступлений и обоснованным страхом, что продукты на основе технологий искусственного интеллекта могут легко попасть в плохие руки (как, например, угнанный беспилотный автомобиль). Мы уже видели, как можно дистанционно вскрывать современные отнюдь не беспилотные автомобили и как во время вождения может давать сбои их электронная «начинка»[202]202

Somers, J., “The Coming Software Apocalypse,” The Atlantic. 2017.

[Закрыть]. В наше время засилья хакеров все операции с использованием ИИ должны проверяться: не используются ли данные, которые могут повредить систему, не перехватывают ли команды программы-боты или вредоносное программное обеспечение, не имеют ли место случаи «войны ИИ против ИИ», когда базовая система отвергает чужеродную программу.

С другой стороны, предпринимаются и усилия по использованию ГНС для содействия кибербезопасности. Разумеется, пока они не увенчались успехом, так как имели место массовые утечки данных в компаниях Equifax, Yahoo, Under Armour (приложение MyFitnessPal) и многих других. Пожалуй, больше надежд вселяет концепция так называемой дифференциальной конфиденциальности, при которой используют семейство алгоритмов машинного обучения под названием Конфиденциальная агрегация обучающих комплексов (PATE): так идентифицируется каждый конкретный человек, но без доступа к его индивидуальным медицинским документам[203]203

Papernot, N., and I. Goodfellow, “Privacy and Machine Learning: Two Unexpected Allies?” cleverhans-blog. 2018.

[Закрыть]. Однако такое ограниченное использование данных может привести к предвзятости модели по отношению к определенным подгруппам, что подчеркивает важность соблюдения баланса при взаимодействии конфиденциальности и предрассудков.

Этика и публичная политика

Неудивительно, что на фоне скорости, с какой в последнее время совершенствуется ИИ, некоторые начали призывать к ограничению этой скорости и к введению новых регулирующих мер[204]204

Etzioni, O., “How to Regulate Artificial Intelligence,” The New York Times. 2017; Simonite, T., “Do We Need a Speedometer for Artificial Intelligence?” Wired. 2017.

[Закрыть]. Директор Алленовского института искусственного интеллекта Орен Этциони – один из тех, кто призывает к «мерам, которые могли бы по крайней мере замедлить прогресс искусственного интеллекта в интересах безопасности и из соображений предосторожности». Не ИИ создал большую часть проблем, о которых говорится в этой главе, поскольку это классические этические проблемы, – но именно ИИ усугубил их, что подтверждается историями «гей-радаров», сотрудничества NHS с компанией DeepMind, непреднамеренным «продвижением» расовых предрассудков или неравенства. Однако реакции искусственного интеллекта не всегда бывают классическими. Есть два фундаментальных уровня этики ИИ: машинная этика, которая относится к самой системе искусственного интеллекта, и этика в более широком смысле, характерном не только для алгоритмов.

Типичным примером машинной этики может служить поведение беспилотного автомобиля при выборе наименьшего зла в случае непредвиденной ситуации на дороге, когда независимо от решения все равно погибнут люди. Это современная версия «проблемы вагонетки», сформулированной более 50 лет назад. Жан-Франсуа Боннефон и его коллеги подробно исследовали проблему беспилотного автомобиля с использованием моделирования и вводных данных, полученных на основании опыта более 1900 человек[205]205

Bonnefon, J. F., A. Shariff, and I. Rahwan, “The Social Dilemma of Autonomous Vehicles.” Science, 2016. 352 (6293): pp. 1573–1576.

[Закрыть]. Ни в одном из трех сценариев (см. рис. 5.1) нет оптимального выбора; вопрос заключается только в том, кто именно погибнет и сколько будет жертв – пассажир автомобиля, пешеход или несколько пешеходов. Правильного ответа здесь нет и не может быть: сталкиваются моральные ценности, культурные нормы и личные интересы. Однако большинство респондентов не делают выбор в пользу «высшего блага» и не жертвуют собой. Понятно, что решить эти проблемы при разработке алгоритма управления беспилотным автомобилем будет чудовищно трудно[206]206

Там же.

[Закрыть], и эту задачу уже назвали «одной из самых острых в области современного искусственного интеллекта»[207]207

Там же.

[Закрыть]. Есть и другой пласт этой проблемы: кого следует привлечь к разработке алгоритма – потребителей, производителей, власти? Как и следовало ожидать, бизнес без излишнего восторга относится к государственному регулированию; многие компании, включая Microsoft и Google, создали свои внутренние комитеты по этике, утверждая, что вмешательство государственных регуляторов может оказаться контрпродуктивным, так как задержит внедрение беспилотных автомобилей из-за пустяковых частных случаев. А между тем уже очевидно, что автономные автомобили позволят снизить общее число аварий на дорогах со смертельным исходом. Но мы не смотрим на вопрос столь широко. Каждый год люди-водители убивают на дорогах 1,25 млн человек, в большинстве случаев из-за человеческой ошибки, но мы – представители гражданского общества – и бровью не ведем[208]208

. Road traffic injuries, ed. World Health Organization. 2018.

[Закрыть]. А когда в эту гремучую смесь подмешивается ИИ, это вызывает лишь когнитивные искажения, но никак не признание конечной выгоды. Когда беспилотный автомобиль сбивает человека, повсюду поднимается крик: беспилотные машины опасны! Первый случай смерти пешехода в результате наезда беспилотного автомобиля (в рамках испытаний компании Uber) имел место в 2018 г. в Аризоне. Алгоритм автомобиля засек в темноте человека на дороге, но не начал торможение, а женщина-водитель не среагировала, потому что положилась на автоматику[209]209

Howard, B., “Fatal Arizona Crash: Uber Car Saw Woman, Called It a False Positive,” Extreme Tech. 2018.

[Закрыть]. Как ни странно, здесь я скорее поставлю под сомнение этические принципы компании, а не сам искусственный интеллект, так как именно компания устроила испытания без должного тестирования и без надежной страховки со стороны водителя-человека.

Рис. 5.1. Три дорожные ситуации с участием беспилотного автомобиля, которые неизбежно приводят к катастрофе. Автомобиль должен решить: убить несколько пешеходов или одного прохожего (А); убить одного пешехода или своего пассажира (B); убить несколько пешеходов или своего пассажира (C). Источник: с изменениями из: J. F. Bonnefon et al., “The Social Dilemma of Autonomous Vehicles,” Science (2016): 352 (6293), 1573–1576.

Вопросы законодательного регулирования применения ИИ особенно важны в медицине. Законодательный надзор за медицинскими алгоритмами еще только вводится, и одобрены были лишь некоторые из них. Но вопрос не только в том, какое количество заявок на ИИ-приложения было представлено в FDA, и не в том, что их будет еще больше. Эти инструменты непрерывно развиваются и совершенствуются, им требуются все более обширные массивы данных, а потенциал их самообучения растет. Это потребует разработки новых основных правил рассмотрения и утверждения заявок, проведения послепродажного надзора и привлечения в надзорные и регулирующие ведомства нового персонала с опытом работы в области ИИ. Дать зеленый свет алгоритму, не прошедшему надлежащую проверку, или алгоритму, который можно легко взломать, – это все равно что сознательно закрыть глаза на катастрофические последствия.

Озабоченность этическими пробелами и возможным вредом привела не только к учреждению института AINow, но и к другим мерам по содействию безопасности и соблюдению этических норм при использовании ИИ: например, были созданы специальные организации (OpenAI, Pervade, Partnership on AI, институт Future of Life), учрежден международный саммит AI for Good, опубликованы работы ученых Калифорнийского университета в Беркли, Гарвардского университета, Оксфордского университета и Кембриджского университета. Тем не менее, как подчеркивают в институте AINow, ни одна ИТ-компания не отслеживает собственную приверженность этическим нормам. Это мне и вспомнилось, когда я недавно читал свежий информационный бюллетень компании Infosys о медицинском искусственном интеллекте – он назывался «ИИ в здравоохранении: баланс между эффективностью и этикой»[210]210

. AI for Healthcare: Balancing Efficiency and Ethics, ed. Infosys. 2017. https://www.info-sys.com/smart-automation/Documents/ai-healthcare.pdf.

[Закрыть]. Хотя в материале говорилось, что и отрасль в целом, и отдельные организации нуждаются в «установлении этических стандартов и обязательств», в нем не было никаких указаний на то, каковы должны быть эти стандарты и обязанности. В здравоохранении существует даже риск целенаправленного создания заведомо неэтичных алгоритмов – например, составление рекомендаций на основании суммы страховки или уровня доходов. Абсолютно ясно, что в этой области предстоит еще очень много работы.

Внимание! Это не конец книги.

Если начало книги вам понравилось, то полную версию можно приобрести у нашего партнёра - распространителя легального контента. Поддержите автора!Правообладателям!

Данное произведение размещено по согласованию с ООО "ЛитРес" (20% исходного текста). Если размещение книги нарушает чьи-либо права, то сообщите об этом.Читателям!

Оплатили, но не знаете что делать дальше?