Автор книги: Ян Лекун

Жанр: Техническая литература, Наука и Образование

Возрастные ограничения: +12

сообщить о неприемлемом содержимом

Текущая страница: 3 (всего у книги 25 страниц) [доступный отрывок для чтения: 6 страниц]

Преданные последователи

Тем не менее, и во времена застоя в 1970-х и 1980-х гг. некоторые ученые продолжали работать над нейронными сетями, хотя научное сообщество считало их сумасшедшими, чуть ли не фанатиками. Я имею в виду Теуво Кохонена, финна, который написал об «ассоциативных воспоминаниях» – теме, близкой к нейронным сетям. Я также говорю и о группе японцев – в Японии существует изолированная инженерная экосистема, отличная от западной, – и среди них о математике Сун-Ити Амари и исследователе искусственного интеллекта Кунихико Фукусима. Последний работал над машиной, которую он назвал «когнитроном», по аналогии с термином «перцептрон». Он создал две его версии: «когнитрон» 1970-х и «неокогнитрон» 1980-х. Как и Розенблатт в свое время, Фукусима был вдохновлен достижениями нейробиологии, особенно открытиями американца Дэвида Хьюбела и шведа Торстен Н. Визеля.

Эти два нейробиолога получили Нобелевскую премию по физиологии в 1981 г. за свою работу над зрительной системой кошек. Они обнаружили, что зрение возникает в результате прохождения визуального сигнала через несколько слоев нейронов, от сетчатки до первичной зрительной коры, затем в другие области зрительной коры, и, наконец – в нижневисочную кору. Нейроны в каждом из этих слоев выполняют особые функции. В первичной зрительной коре каждый нейрон связан только с небольшой областью поля зрения, а именно со своим рецепторным полем. Такие нейроны называются «простыми». В следующем слое другие нейроны включают активацию предыдущего слоя, что помогает поддерживать представление изображения, если объект немного перемещается в поле зрения. Такие нейроны называются «сложными».

Таким образом, Фукусима был вдохновлен идеей первого слоя простых нейронов, которые обнаруживают простые узоры в небольших рецепторных полях, выдающих изображение, и сложных нейронов в следующем слое. Всего в неокогнитроне было пять слоев: простые нейроны – сложные нейроны – простые нейроны – сложные нейроны, и затем «классификационный слой», подобный перцептрону. Он, очевидно, использовал для первых четырех уровней некоторый алгоритм обучения, но последний был «неконтролируемым», то есть он не принимал во внимание конечную задачу. Такие слои обучались «вслепую». Только последний слой обучался под наблюдением (как и перцептрон). У Фукусимы не было алгоритма обучения, который регулировал бы параметры всех слоев его неокогнитрона. Однако его сеть позволяла распознавать довольно простые формы, например, символы чисел.

В начале 1980-х гг. идеи Фукусимы поддерживали и другие ученые. Некоторые североамериканские исследовательские группы также работали в этой области: психологи Джей Макклелланд и Дэвид Румелхарт, биофизики Джон Хопфилд и Терри Сейновски, и ученые-компьютерщики, в частности Джеффри Хинтон – тот самый, с которым я впоследствии разделю Премию Тьюринга, присужденную в 2019 г.

Мой выход на сцену

Я начал интересоваться всеми этими темами в 1970-х гг. Возможно, любопытство к ним зародилось во мне еще, когда я наблюдал за моим отцом, авиационным инженером и мастером на все руки, который в свободное время занимался электроникой. Он строил модели самолетов с дистанционным управлением. Я помню, как он сделал свой первый пульт для управления небольшой машиной и лодкой во время забастовок в мае 1968 г., когда он проводил много времени дома. Я не единственный в семье, кому он передал свою страсть к любимому делу. Мой брат, который на шесть лет младше меня, тоже сделался ученым-компьютерщиком. После академической карьеры он стал исследователем в компании Google.

С самого раннего детства меня манили новые технологии, компьютеризация, покорение космоса… Еще я мечтал стать палеонтологом, потому что меня очень интриговал человеческий интеллект и его эволюция. Даже сегодня я по-прежнему верю, что работа нашего мозга остается самой загадочной вещью в мире. Я помню, как в Париже на большом экране я вместе с моими родителями, а также дядей и тетей – «фанатами» научной фантастики, смотрел фильм «2001: Космическая одиссея». Мне было тогда восемь лет. Фильм затронул все, что я любил: космические путешествия, будущее человечества и восстание суперкомпьютера «Хэл», который готов был убивать ради собственного выживания и успеха миссии. Уже тогда меня волновал вопрос о том, как воспроизвести человеческий интеллект в машине.

Неудивительно, что после школы я захотел воплотить эти мечты в жизнь. В 1978 г. я поступил в Парижскую высшую школу электронной инженерии (École Supérieure d'Ingénieurs en Électrotechnique et Électronique, ESIEE) в которую можно подавать заявление сразу после получения степени бакалавра, без затрат времени на дополнительную подготовку. (Откровенно говоря, длинная учеба – не единственный способ добиться успеха в науке. Я могу это подтвердить на своем примере.) А поскольку учеба в ESIEE предоставляет студенту некоторую свободу, я сумел воспользоваться этим.

Плодотворное чтение

Меня воодушевили новости о дебатах на конференции Cerisy о врожденном и приобретенном знании[16]16

Théories du langage, théories de l'apprentissage: le débat entre Jean Piaget et Noam Chomsky, d.bat recueilli par Maximo Piatelli-Palmarini, Centre Royaumont pour une science de l'homme, Seuil, Points, 1979.

[Закрыть], прочитанные мною в 1980 г. Лингвист Ноам Хомски подтвердил, что в мозге существуют исходно заложенные структуры, позволяющие человеку научиться языку. Психолог Жан Пиаже защищал идею о том, что любое обучение задействует определенные, уже существующие структуры мозга, и что овладение языком осуществляется поэтапно по мере того, как формируется интеллект. Таким образом, интеллект будет результатом обучения, основанного на обмене информацией с внешним миром. Эта идея мне понравилась, и мне стало интересно, как ее можно применить в отношении машины. В этой дискуссии принимали участие именитые ученые, в том числе Сеймур Паперт. В ней он восхвалял перцептрон, который описывал как простую машину, способную обучаться сложным задачам.

Так я и узнал о существовании обучающейся машины. Эта тема меня просто очаровала! Поскольку я не учился по средам после обеда, я начал рыскать по полкам библиотеки Национального института компьютерных и автоматических исследований в Роккенкуре (National Institute for Research in Digital Science and Technology, сокращенно «Inria»). У этого учреждения самый богатый библиотечный фонд ИТ-литературы в Иль-де-Франс. Я вдруг понял, что на Западе больше никто не работает с нейронными сетями, и с еще большим удивлением обнаружил, что книга, положившая конец исследованиям перцептрона, принадлежит перу того же самого Сеймура Паперта!

Теория систем, которую в 1950-х гг. мы называли кибернетикой, и которая изучает естественные (биологические) и искусственные системы – еще одна моя страсть. Возьмем, например, систему регулирования температуры тела: организм человека поддерживает температуру 37 ℃ благодаря наличию своеобразного «термостата», который корректирует разницу между своей температурой и температурой снаружи.

Меня увлекла идея самоорганизации систем. Каким образом относительно простые молекулы или объекты могут спонтанно организовываться в сложные структуры? Как может появиться интеллект из большого набора простых взаимодействующих нейронов?

Я изучал математические работы по теории алгоритмической сложности Колмогорова, Соломонова и Чайтина. Книга Дуды и Харта[17]17

Richard O. Duda, Peter E. Hart, Pattern Classification and Scene Analysis, p. 6.

[Закрыть], о которой я уже упоминал, стала для меня настольной. Я читал журнал «Биологическая кибернетика» («Biological Cybernetics. Advances in Computational Neuroscience and in Control and Information Theory for Biological Systems», издательство Springer), посвященный математическим моделям работы мозга или живых систем.

Все эти вопросы, оставленные без ответа в период застоя искусственного интеллекта, не выходили у меня из головы, и у меня постепенно стало формироваться убеждение: если мы хотим создавать интеллектуальные машины, недостаточно, чтобы они работали только логически, они должны быть способными учиться, совершенствоваться на собственном опыте.

Читая все эти труды, я понимал, что часть научного сообщества разделяет мое виденье проблемы. Вскоре я познакомился с работами Фукусимы и задумался о способах повышения эффективности нейронных сетей неокогнитрона. К счастью, ESIEE предоставлял студентам компьютеры, которые для того времени были очень мощными. Мы писали программы с Филиппе Метсу, школьным другом, любителем искусственного интеллекта, как и я, хотя его больше интересовала психология обучения детей. Преподаватели математики согласились заниматься с нами дополнительно. Вместе мы пытались моделировать нейронные сети. Но эксперименты отнимали очень много сил: компьютеры не тянули наши эксперименты, а написание программ было сплошной головной болью.

На четвертый год обучения в ESIEE, одержимый этим исследованием, я догадался о не совсем математически обоснованном правиле обучения многослойных нейронных сетей. Я представил алгоритм, который будет распространять сигналы в обратном направлении по сети, начиная с выходного слоя, чтобы обучать сеть от начала до конца. Я назвал этот алгоритм HLM (от Hierarchical Learning Machine)[18]18

См. главу 5 «Мой HLM!».

[Закрыть].

Я очень гордился своей идеей… HLM является предшественником алгоритма «обратного распространения градиента», который сегодня повсеместно используется для обучения систем глубокого обучения. Вместо распространения обратных градиентов в сети, как это происходит сегодня, HLM распространял желаемые состояния для каждого нейрона. Это позволяло использовать бинарные нейроны, что являлось преимуществом, учитывая медлительность компьютеров того времени для выполнения умножения. HLM был первым шагом в обучении многоуровневых сетей.

Коннекционистские модели обучения

Летом 1983 г. я получил высшее образование по специальности «инженер». Тогда же я наткнулся на книгу, в которой рассказывалось о работе небольшой группы французов, интересующихся самоорганизующимися системами и сетями автоматов. Они экспериментировали в бывшем помещении Политехнической школы на холме Святой Женевьевы в Париже. Эта лаборатория сетевой динамики (Laboratoire de dynamique de réseau, или LDR) была независимой, хотя ее члены занимали должности в разных высших учебных заведениях. У них было мало денег, не было планового бюджета, а их компьютер нуждался в ремонте. Это означало, что исследования машинного обучения во Франции висят на волоске! Я решил примкнуть к ним. Я мог реально помочь им, потому что эти ученые не занимались изучением старых публикаций по нейронным сетям, как это делал я.

Я решил объяснить им, что меня интересует эта тема и что в своей инженерной школе я занимаюсь схожей тематикой. Я работал в их группе, продолжая учебу в аспирантуре в Университете Пьера и Марии Кюри. В 1984 г. мне нужно было подать заявление на защиту докторской диссертации. Я занимал должность младшего научного сотрудника ESIEE по гранту, но мне нужно было найти себе научного руководителя. Много времени я работал с Франсуазой Фогельман-Суле (сейчас Сули-Фогельман), которая в то время преподавала компьютерные науки в Университете Париж-V и, по логике вещей, именно она должна была бы курировать мою диссертацию, но у нее не было на это полномочий, поскольку она еще не прошла государственную сертификацию на право руководить аспирантами (необходимую во многих европейских странах).

Поэтому я обратился к единственному члену лаборатории, который мог курировать диссертацию по информатике, – Морису Милграму, профессору информатики и инженерии Технологического университета Компьена. Он согласился, но дал понять, что не сможет мне сильно помочь, потому что ничего не знает о нейронных сетях, но я и так был безмерно благодарен ему за эту помощь. Поэтому я посвятил свое время одновременно ESIEE (и ее мощным компьютерам) и LDR (и ее интеллектуальной среде). Я попал на ранее неизвестную мне территорию, и это было интересно.

За рубежом исследования, близкие к моим, набирали обороты. Летом 1984 г. я сопровождал Франсуазу Фогельман в Калифорнию, где прошел месячную стажировку в известной многим лаборатории Xerox PARC.

В то время, я помню, в мире было два человека, с которыми я мечтал встретиться: Терри Сейновски – биофизик и нейробиолог из Университета Джона Хопкинса в Балтиморе, и Джеффри Хинтон из Университета Карнеги-Меллон в Питтсбурге – тот самый, кто поделит с Йошуа Бенджио и мной Премию Тьюринга в 2019 г. В 1983 г. Хинтон и Сейновски опубликовали статью о машинах Больцмана[19]19

Машиной Больцмана называется один из видов нейронных сетей. – Прим. ред.

[Закрыть], которая содержит процедуру обучения сетей со «скрытыми нейронами», то есть нейронами в промежуточных слоях между входом и выходом. Я увлекся этой статьей именно потому, что в ней говорилось об обучении многослойных нейронных сетей. «Главный» вопрос в моей работе! Эти люди сыграли важную роль в моей жизни!

Лез-Уш

Моя профессиональная жизнь изменилась в феврале 1985 г. во время конференции в Лез-Уш, в Альпах. Там я встретился с лучшими представителями мировой науки, интересующимися нейронными сетями: физиками, инженерами, математиками, нейробиологами, психологами и, в частности, членами новой развивающейся исследовательской группы в области нейронных сетей, которая сформировалась внутри легендарной лаборатории Bell Labs. Через три года я попал в эту группу благодаря знакомствам, которые приобрел в Лез-Уш.

Встреча была организована теми французскими исследователями из LDR, с которыми я уже работал: Франсуазой, ее тогдашним мужем Жераром Вайсбухом, профессором физики ENS, и Эли Биненштоком – нейробиологом-теоретиком, работавшим в то время в CNRS. Конференция собрала вместе физиков, интересующихся «спиновыми стеклами», а также ведущих физиков и нейробиологов.

Спин – это свойство элементарных частиц и атомов, которое можно описать по аналогии с маленькими магнитами, с обращенными вверх или вниз полюсами. Эти два значения спина можно сравнить с состояниями искусственного нейрона: он либо активен, либо неактивен. Он подчиняется тем же уравнениям. Спиновые стекла представляют собой своего рода кристалл, в котором примесные атомы имеют магнитный момент. Каждый спин взаимодействует с другими спинами на основе связанных весовых показателей.

Если весовой коэффициент положительный, они, как правило, выстраиваются в одном направлении. Если вес отрицательный, они противопоставляются. Мы связываем значения +1 со спином «вверх», а –1 со спином «вниз». Каждый примесный атом принимает ориентацию, которая является функцией взвешенной суммы ориентаций соседних примесных атомов. Другими словами, функция, определяющая, будет ли спин идти вверх или вниз, аналогична функции, которая делает искусственный нейрон активным или неактивным.

После основополагающей статьи Джона Хопфилда[20]20

John J. Hopfield, Neural networks and physical systems with emergent collective computational abilities, Proceedings of the National Academy of Sciences, 1982, 79 (8), p. 2554–2558, DOI:10.1073/pnas.79.8.2554.

[Закрыть], в которой были описаны аналогии между спиновыми стеклами и искусственными нейронными сетями, многие физики начали интересоваться и самими сетями, и их обучением – темами, по-прежнему не приветствовавшимися их коллегами – инженерами и компьютерщиками.

В Лез-Уш я был одним из самых молодых исследователей, и мне пришлось общаться на английском языке о многоуровневых сетях и алгоритме HLM, моем предшественнике алгоритмов обратного распространения. Я только начал подготовку своей диссертации, и нервничал, выступая перед столь именитой аудиторией.

Меня особенно привлекли две личности: Ларри Джекел, глава отдела Bell Labs (позже мне самому довелось работать в этом отделе) и Джон Денкер – настоящий ковбой из Аризоны: джинсовый костюм, большие бакенбарды, ковбойские сапоги… Этот не очень похожий на ученого человек, только что защитивший диссертацию, был невероятно уверен в себе! Когда на него находило вдохновение, он мог быть чертовски убедителен и изобретательно отстаивал свою точку зрения, причем без агрессии и часто вполне обоснованно. Франсуаза Фогельман говорила мне: «У ребят из Bell Labs огромное преимущество. Когда вы только хотите сделать что-то новое, то выясняется, что это либо уже было сделано в Bell Labs десять лет назад, либо это просто не работает». Черт возьми!

Так вот, я выступал с речью о многослойных сетях, в которых (уже!) никто ничего не понимал. В конце Джон Денкер поднял руку. Я напрягся. Но он просто сказал: «А это имеет место быть! Благодаря тебе я многое понял…» Он сказал это прямо перед всей этой публикой! Он и его руководитель Ларри Джекел меня не забыли. Год спустя они пригласили меня прочитать лекцию в их лаборатории. Еще двумя годами позже я появился на собеседовании, а через три года я стал членом их команды!

В Лез-Уш я встретил и Терри Сейновски, соавтора статьи Джеффри Хинтона о машинах Больцмана. Он появился там уже после моего выступления, но я поймал его во второй половине дня и объяснил свою работу над многоуровневыми сетями. Я подозревал, что ему будет это интересно. Он терпеливо слушал, но ничего не сказал о том, что он и Джеффри Хинтон уже работают над обратным распространением. Джеффри удалось заставить этот алгоритм работать, но еще не все об этом знали – и я тоже.

Самые прекрасные идеи заразительны. Принцип обратного распространения Джеффри позаимствовал у Дэйва Рамелхарта из Калифорнийского университета в Сан-Диего, у которого он несколькими годами ранее проходил стажировку после защиты диссертации. К 1982 г. Дэйв смог разработать и запрограммировать этот метод, но не смог заставить его работать. Он пришел к Джеффри, который ответил: «Он не будет работать из-за проблемы локальных минимумов»[21]21

См. Главу 4, «Висячие долины».

[Закрыть].

В итоге Дэйв сдался. Но во время работы над машиной Больцмана Джеффри понял, что работать с локальными минимумами не так сложно, как он думал. Поэтому он реализовал метод Дэйва Рамельхарта на языке Lisp на своей Lisp-машине от компании Symbolics. И метод заработал!

Итак, во время нашего обсуждения в Лез-Уш Терри понял, что мой алгоритм HLM очень похож на обратное распространение. Он сам уже работал над применением метода обратного распространения ошибки, который через несколько месяцев стал весьма популярным. Мне он об этом не сказал. Но вернувшись в США, он признался Джеффри: «Во Франции есть ребенок, который работает над тем же, что и мы!»

Весной того же года я написал первую самостоятельную статью (признаться, несколько выпадавшую из канонов научной литературы) о своей разработке. Мне удалось обнародовать ее на конгрессе по когнитивным исследованиям в июне 1985 г., первом конгрессе во Франции, объединяющем ИИ, нейронные сети, когнитивные науки и нейробиологию. Джеффри Хинтон был главным спикером. Он прочитал вводную лекцию, в которой рассказал о машинах Больцмана. В конце концов, вокруг него собралась группа из 50 человек. Я хотел подойти к нему, но не было возможности. И тут я увидел, как он поворачивается к Дэниэлу Хэндлеру, одному из организаторов конференции, и услышал, как он спросил: «Вы знаете кого-нибудь по имени Ян Лекун?» Дэниэл оглянулся вокруг. Я закричал: «Я здесь!» Дело было в том, что Джеффри увидел мою статью и попытался ее перевести, хотя французским владел слабо. Тем не менее, он сумел понять, что я – именно тот «ребенок», о котором сказал ему Терри.

Мы с Джеффри встретились на следующий день за обедом. Он объяснил мне принцип обратного распространения. Хотя он знал, что я и так его понимаю! Он сказал мне, что пишет статью и процитирует в ней мою. Я чуть не впал в прострацию. Мы быстро поняли, что наши интересы, наши подходы, наше мышление схожи. Джеффри пригласил меня в летнюю школу коннекционистских моделей в Карнеги-Меллон в следующем году, и я, конечно же, согласился. (Исследователи когнитивных наук предпочитали для обозначения нейронных сетей использовать термин «коннекционистские модели».)

Использование обратного распространения градиента[22]22

По-русски этот метод сейчас называться обычно «методом обратного распространения ошибки». – Прим. ред.

[Закрыть]

Изобретения не возникают из ничего. Они являются результатом проб, ошибок, разочарований и дискуссий, и зачастую для их реализации требуется много времени. Таким образом, «рубежи» искусственного интеллекта расширялись благодаря целой серии открытий. Популяризация градиентного обратного распространения в 1980-х гг. позволила обучать многослойные нейронные сети, состоящие из тысяч нейронов, организованных по слоям, с сотнями тысяч соединений. Каждый слой нейронов объединяет, обрабатывает и преобразует информацию из предыдущего слоя и передает результат следующему слою, пока в конечном слое не сформируется ответ. Такая многоуровневая архитектура обеспечивает потрясающую пропускную способность[23]23

Пропускная способность нейронной сети – это среднее арифметическое между объемами обрабатываемой и создаваемой информации нейронной сетью за единицу времени. – Прим. ред.

[Закрыть] этих многоуровневых сетей. Позже мы поговорим о глубоком обучении.

Но в 1985 г. идея, что для многоуровневой сети может появиться процедура обучения, все еще с трудом воспринималась. Физиков интересовала аналогия между полносвязными нейронными сетями («сетями Хопфилда») и спиновыми стеклами. Они видели в них модель ассоциативной памяти в мозге. «Мадленка» Пруста[24]24

«Мадлен» – французское бисквитное печенье небольшого размера. Во французском языке выражение «мадленка Пруста» превратилось в метафору, обозначающую предмет, вкус или запах, вызывающие наплыв воспоминаний. – Прим. ред.

[Закрыть] по форме, запаху и вкусу относится к образам и связанным с ними чувствам, то есть к воспоминаниям. Многоуровневые сети работают скорее в режиме восприятия: с помощью каких механизмов можно идентифицировать мадлен только по его форме? Физики не сразу это поняли.

Все изменилось в 1986 г. Терри Сейновски опубликовал технический отчет о NetTalk, многоуровневой сети, основанной на обратном распространении информации, которая «училась» читать вслух. Система транскрибирует английский текст в последовательность фонем (элементарных речевых звуков), передаваемых на синтезатор речи. Легко преобразовать текст в речь на французском языке, но чрезвычайно сложно на английском. В начале обучения система заикалась, как ребенок, который учится говорить, однако со временем ее произношение улучшилось. Терри Сейновски приехал прочитать лекцию в Высшей школе перед обомлевшей аудиторией. Внезапно все захотели со мной пообщаться. Многослойные сети вдруг стали интересными, и я был знатоком в этой области!

Годом раньше я обнаружил, что обратное распространение может быть сформулировано математически с помощью Лагранжева формализма (названного в честь франко-итальянского математика XVIII в. и астронома Жозефа-Луи Лагранжа). Это вид формализма, на котором базировалась классическая механика, квантовая механика и теория «оптимального управления». Я понимал, что метод, аналогичный алгоритму обратного распространения ошибки, уже был предложен теоретиками оптимального управления в начале 1960-х гг. Он известен как алгоритм Келли-Брайсона или «метод помощника», подробно описанный в справочнике Артура Брайсона и Ю-Чи Хо «Applied Optimal Control, Arthur E. Bryson, Yu-Chi Ho, 1975», опубликованном в 1969 г.

Эти исследователи были далеки от идеи об использовании данного метода для машинного обучения или нейронных сетей. Их интересовали планирование и системы управления. Например, как управлять траекторией ракеты, чтобы она попала на точную орбиту и успешно встретилась с другим космическим кораблем, израсходовав при этом как можно меньше топлива. Однако с математической точки зрения эта проблема очень похожа на вопрос о настройке синаптических весов многослойной нейронной сети, чтобы результат последнего слоя стал желаемым.

Позже я узнал, что несколько исследователей очень близко подошли к открытию обратного распространения ошибки. В 1960-х и 1970-х гг. некоторые из них открыли «автоматическое дифференцирование в обратном режиме» – основной блок для расчета градиентов при обратном распространении. Но они использовали его для облегчения численного решения дифференциальных уравнений или оптимизации функций. Об обучении в многослойных сетях тогда никто и не думал. Никто – кроме, возможно, Пола Вербоса, студента из Гарварда, который прошел курсы Ю-Чи Хо и который в своей диссертации 1974 г. предложил использовать для обучения то, что он называл «упорядоченными производными». Много позже он смог испытать свой метод на практике.

Итак, в июле 1986 г. я провел две недели в Питтсбурге в Летней школе коннекционистских моделей в Университете Карнеги-Меллона, куда меня пригласил Джеффри Хинтон. Я сомневался, нужно ли мне лететь в Соединенные Штаты: моя жена была беременна нашим первым ребенком, а роды ожидались через четыре недели после моего возвращения…

Я помню эту поездку и соотношу ее с основанием сообщества исследователей нейронных сетей. Я подружился с Джеффри и Майклом Джорданом, который только защитил диссертацию. Почему только его назвали Майклом – он был франкофилом и говорил по-французски лучше, чем я по-английски! На пикниках в Летней школе он исполнял песни Жоржа Брассенса, аккомпанируя себе на гитаре.

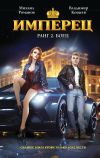

Рис. 2.1. Участники Летней школы по коннекционистским моделям 1986 г. в Университете Карнеги-Меллона (Питтсбург, США)

На фото мы видим Станисласа Дехаена (SD), Майкла Джордана (MJ), Джея Макклелланда (JMcC), Джеффри Хинтона (GH), Терри Сейновски (TS) и меня (YLC). Многие участники встречи тоже станут видными фигурами в области машинного обучения, искусственного интеллекта и когнитивных наук: Энди Барто, Дэйв Турецки, Джерри Тезауро, Джордан Поллак, Джим Хендлер, Майкл. Мозер, Ричард Дурбин и ряд других (© Организаторы летней школы).

Хотя я был всего лишь аспирантом, Джеффри предложил мне выступить с речью, объясняя это тем, что именно я создал алгоритм обратного распространения. За ужином, запив его хорошей бутылкой бордо, которую я привез с собой в багаже, он сказал мне, что через год планирует уйти из университета Карнеги-Меллон[25]25

Хинтон преподавал там в должности профессора с 1982 г. – Прим. ред.

[Закрыть] и перейти в Университет Торонто. «Вы хотите присоединиться ко мне в качестве младшего исследователя?» Конечно! У меня оставался лишь год на то, чтобы защитить докторскую.

Революция продолжалась. Публикация статьи Рамельхарта-Хинтона-Уильямса об обратном распространении произвела эффект взорвавшейся бомбы[26]26

D. E. Rumelhart, G. E. Hinton, R. J. Williams, Learning internal representations by error propagation, in D. E. Rumelhart, J. L. McClelland, PDP Researche Grou Parallel Distributed Processing: Explorations in the Microstructure of Cognition, MIT Press, 1986, vol. 1, p. 318–362.

[Закрыть]. Новости об успехе NetTalk распространялись как лесной пожар. Сообщество исследователей нейронных сетей быстро пополнялось все новыми участниками.

Мое программное обеспечение для моделирования нейронных сетей и обучения методом обратного распространения ошибки – все еще называемое HLM – представляло интерес для некоторых французских производителей. В частности, программу купила компания Thomson-CSF (теперь Thales).

Я получил докторскую степень в июне 1987 г. Диссертацию в Университете Пьера и Марии Кюри (теперь переименованном в Университет Сорбонны) я защищал в буквальном смысле на костылях, потому что в апреле сломал лодыжку, экспериментируя с новым методом передвижения по песку при помощи паруса! Джеффри Хинтон входил в состав жюри вместе с Морисом Милграмом, Франсуазой Фогельман-Суле, Жаком Питра (один из столпов исследований в области символического ИИ во Франции) и Бернаром Анжениолем (директором исследовательской группы Thomson-CSF). Через месяц я присоединился к Джеффри в Торонто вместе с женой и нашим ребенком, которому тогда исполнился всего лишь год. Моя жена согласилась отодвинуть на второй план свою карьеру фармацевта и заниматься сыном во время нашего пребывания в США, которое, как мы считали, не должно было продлиться более года…

Я взял с собой одного из своих друзей, Леона Ботту, студента, которого я встретил в начале 1987 г., когда он учился на последнем курсе Политехнической школы. Он проявил интерес к нейронным сетям и решил пройти со мной выпускную стажировку, не сообщив администрации школы, что я на тот момент еще не защитил докторскую. У меня уже были планы написать новое программное обеспечение для создания и обучения нейронных сетей. Это должен был быть симулятор, управляемый интерпретатором Lisp (особенно гибкого и интерактивного языка программирования). Я попросил Леона создать такой интерпретатор[27]27

Язык Lisp был создан в конце 50-х годов автором термина «искусственный интеллект» специально для работы с ИИ. Долгое время он, в различных вариантах, которых было очень много, занимал в разработке ИИ то место, которое теперь занимает Python. Как и Python, Lisp является интерпретируемым языком, он нуждается в запущенной программе – интерпретаторе, которая построчно исполняет (интерпретирует) написанный на языке Lisp программный код. Интерпретатор, в свою очередь, может быть написан для разных целей и с разными особенностями. Леон Ботта, очевидно, написал интерпретатор Lisp, специализированный именно для управления симулятором Лекуна. – Прим. ред.

[Закрыть], что он и сделал буквально за три недели. Нашему сотрудничеству способствовал тот факт, что мы работали на одинаковых компьютерах: Amiga от компании Commodore. В отличие от ПК и Mac того времени, компьютеры Amiga обладали свойствами, аналогичными свойствам рабочих станций Unix, широко распространенных в ИТ-отделах по обе стороны Атлантики: они программируются на языке C с помощью компилятора gcc и текстового редактора Emacs. Я писал диссертацию на своем Amiga, используя компьютерную систему обработки текстов LaTeX. Мы обменивались программами удаленно, подключая к нашим компьютерам сеть Minitel.

Мы назвали новую программу SN (от термина «Neuronal Simulator», т. е. «нейронный симулятор»). Ее написание положило начало сотрудничеству и дружбе, продлившимся долгие годы: и сегодня офис Леона находится рядом с моим, в помещении FAIR[28]28

Исследование искусственного интеллекта компании Facebook.

[Закрыть] в Нью-Йорке.

В Торонто я закончил работу над SN и модифицировал эту программу, чтобы реализовать идею архитектуры нейронной сети, адаптированной к распознаванию изображений, которую я обдумывал уже некоторое время (теперь эта архитектура называется «сверточной сетью»; см. Главу 6). Она была вдохновлена неокогнитроном Фукусимы, но использовала более «классические» нейроны и управлялась алгоритмом обратного распространения. В то же время Джеффри Хинтон разработал другой, более простой тип сверточной сети, которую он использовал для распознавания речи. Он назвал ее TDNN (Time Delay Neural Network, т. е. «нейронная сеть с временной задержкой»).

В конце 1987 г. меня пригласили прочесть лекцию в Монреальском исследовательском центре компьютерных наук – институте, связанном с университетом Макгилла. В конце моего выступления один из молодых магистрантов задал ряд вопросов, из которых было очевидно, что он серьезно подошел к многослойным нейронным сетям. В то время в этой области было очень мало исследователей. Он задавался вопросом о том, как адаптировать архитектуру нейронных сетей, чтобы они могли обрабатывать протяженные во времени сигналы, такие как речь или текст. Я запомнил его имя: Йошуа Бенджио. Его вопросы были настолько актуальны, что я пообещал себе не упускать его из виду и начать с ним сотрудничество после завершения его учебы. Позже я нашел его уже работающим в Bell Labs, куда его взяли после защиты докторской диссертации и недолгой работы в Массачусетском технологическом институте.